从业这些年,我被问得最多的问题之一就是:“这个云厂商的SLA靠谱吗?他们写的99.99%可用性,到底算不算数?” 每当这时,我都会想起自己早期踩过的坑:一个关键服务因为依赖的云数据库实例意外重启,中断了将近半小时,直接影响了下游客户。我去翻看合同,却发现那个数据库服务的SLA是99.95%,按照它的赔偿公式算下来,我拿到的服务抵扣券,可能连当月账单的零头都不到。那一刻我才恍然大悟,云厂商口中的 SLA 到底靠不靠谱? 这个问题,远不止是看一个百分比数字那么简单。

今天,我就以一个“过来人”的身份,结合自己亲身经历和这些年对主流云厂商协议的“研读”,和你深度聊聊SLA这张“保险单”里的门道。我们不光要看它承诺了什么,更要看清它没承诺什么,以及当问题真发生时,我们该如何应对。

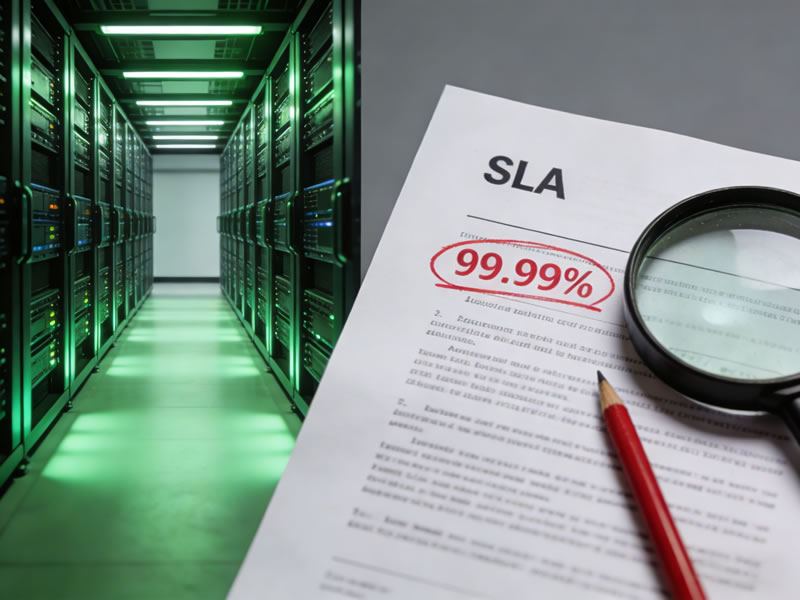

SLA到底是什么?不只是那个诱人的百分比

首先,我们得统一认知。SLA,服务等级协议,本质是云服务商对你做出的一份量化承诺。最常见的呈现方式就是“可用性”,比如99.9%、99.95%、99.99%。这几个小数点后数字的差异,听起来微不足道,但换算成年度允许的宕机时间,差距就惊人了:

- 99.9%(三个九):一年允许的宕机时间约为8小时46分钟。

- 99.95%(三个半九):一年允许的宕机时间约为4小时23分钟。

- 99.99%(四个九):一年允许的宕机时间约为52分钟。

看到这里,你是不是觉得必须追求四个九甚至更高?别急,这只是故事的开始。这个百分比,通常只针对单一、特定的服务,比如一个虚拟机实例、一个对象存储桶、一个负载均衡器。而你的真实业务,是一个由计算、网络、存储、数据库等多个服务串联起来的复杂系统。任何一个环节出问题,都可能导致你的业务不可用。但云厂商的SLA,极少会为你这个业务整体的可用性背书。这就是第一个认知偏差:服务可用性不等于业务可用性。

拆解SLA条款:藏在细节里的“魔鬼”

当你点开一份云厂商的SLA文档,如果只盯着首页的百分比,那就太天真了。真正的玄机,都在后面的条款里。下面这些关键点,是你必须拿着“放大镜”看的:

1. 服务信用/赔偿计算:你的损失,真的能赔回来吗? 这是最核心的部分。几乎所有云厂商的赔偿,都不是现金赔付,而是以“服务信用”的形式,返还到你账户,用于抵扣未来账单。计算公式通常是:(故障时间/承诺的服务周期)x 受影响服务的月度费用。 举个例子,你一个月花1000块买的某服务,它承诺99.95%的月度可用性。结果这个月它故障了30分钟(超出了允许的22分钟)。你的赔偿可能是:(30分钟 / 30天x24小时x60分钟) x 1000元 ≈ 0.7元。是的,你没看错,可能就赔你几块钱。这种赔偿机制,更多是一种象征性的姿态,远不足以覆盖你业务中断带来的真实损失(商誉、客户流失、员工加班成本等)。所以,千万别把SLA赔偿当成业务风险的保险。

2. 排除条款:这些情况,宕机了也不赔! 这一部分往往用密密麻麻的小字写着,但威力巨大。常见的排除情况包括:

- 你的操作不当:比如你误删了实例,错误配置了安全组。

- 你的软件或代码问题:你的应用有BUG导致资源耗尽。

- 预通知的维护:云厂商提前通知的计划内维护。

- 不可抗力:地震、洪水、战争等。

- “Force Majeure”(不可抗力)的宽泛解释:有些厂商的条款可能将第三方网络供应商的问题也包含在内。

- 低于最小索赔门槛:很多SLA会规定,单次故障持续时间必须超过X分钟,才有资格索赔。比如,故障10分钟,即使影响了可用性,也可能因为没达到15分钟的门槛而无法索赔。

3. “可用性”的定义:什么叫“不可用”? 这又是一个关键。通常,云厂商会通过其监控系统,从外部探测点来判定服务是否“不可用”。如果你的实例还在运行,但因为网络路由问题,只有部分地区的用户访问不到,这算不算“不可用”?很可能不算。或者,性能严重下降(如API响应时间从50ms飙升到10秒),但服务没有完全挂掉,这算“不可用”吗?在绝大多数SLA里,这也不算。这种定义上的狭窄性,意味着你的用户体验已经受损,但可能并未触发SLA的赔偿条款。

实战视角:如何让你的业务不依赖SLA的“仁慈”?

明白了SLA的局限性,我们作为用户,正确的思路不是去咒骂条款“坑爹”,而是构建不依赖于单点SLA承诺的韧性架构。这才是云时代的核心生存技能。

1. 拥抱“设计上就假设失败”的架构哲学。 别把任何一个可用区(AZ)、任何一个云服务当成100%可靠的。对于核心业务,至少采用多可用区部署。比如,将你的应用服务器、数据库副本分布在同一个地域的两个不同可用区,并配合负载均衡。这样,单个可用区的电力、网络或硬件故障,不会导致你的业务全军覆没。虽然成本会上升,但这笔钱比任何SLA赔偿都值。

2. 深入理解依赖链,进行“韧性测试”。 画一张你的应用架构图,清晰地标出每一个云服务组件。问自己:如果这个RDS主实例挂了,我的备用实例能多快接管?如果这个ELB不可用,我的DNS能否快速切换到备用?光想不够,要在业务低峰期进行模拟故障演练。主动去停止一个非生产环境的可用区,看看你的系统表现如何。这种“混沌工程”的实践,能暴露出你架构中真正的脆弱点。

3. 建立自己的监控和告警体系,不要只依赖云厂商。 云厂商控制台告诉你服务健康,不等于你的用户能正常访问。你需要在最终用户视角建立监控,从全球不同网络监测你的网站或API的可用性与性能。一旦发现异常,立即启动应急预案,而不是等待云厂商发故障通告。在2025年的今天,利用成熟的APM和合成监控工具,这已经是运维的标配。

4. 仔细阅读SLA,并作为架构设计的输入。 在选择服务时,对比不同云厂商对同类服务的SLA定义。例如,同样是数据库,有的厂商的SLA可能覆盖到只读副本,有的则不。对于SLA承诺较低的服务(比如某些托管服务承诺99.9%),你就要在架构上为其设计更快的替代或降级方案。把SLA文档当作一份重要的技术说明书来读。

当故障真的发生:除了索赔,你更该做什么?

即使你做了万全准备,故障仍可能发生。这时,除了按照流程去提交SLA索赔申请(尽管赔偿不多,但这是你的权利,也能给厂商施加压力),你更应该做这几件事:

- 详细记录时间线:精确记录故障开始、结束时间,你的监控告警时间,以及你采取的所有应对措施。这不仅是内部复盘的需要,也是与云厂商沟通甚至索赔时的关键证据。

- 推动根因分析:主动联系你的客户经理或技术支持,要求提供详细的故障根本原因分析报告。了解是硬件故障、软件BUG、还是网络配置错误,能帮助你评估未来再次发生的风险。

- 复盘并优化架构:召开内部复盘会,基于故障原因,讨论你的架构是否有进一步优化的空间。这次故障是否暴露了某个本该做多可用区部署的服务?你的故障切换流程是否足够自动化?

结论:靠谱的不是SLA,而是你的架构与认知

所以,回到最初的问题:云厂商口中的 SLA 到底靠不靠谱? 我的答案是:SLA本身是“靠谱”的,因为它是一份具有合同效力的商业承诺,厂商通常会严格遵守其白纸黑字写明的条款。它的“不靠谱”,在于我们常常对它抱有不切实际的期望——期望它能保障我们的业务连续性,期望它能补偿我们的真实损失。

SLA的真正价值,不在于事后那点微薄的赔偿,而在于它像一面镜子,迫使云厂商公开其服务的可靠性目标,并倒逼他们持续投入基础设施的健壮性。同时,它也像一记警钟,提醒我们这些使用者:云不是魔法,它依然构建在可能出错的硬件和软件之上。

在2025年,云服务已成为数字世界的基石,我们的核心任务不是寻找一个“永不宕机”的神话,而是通过精心设计的多区域、多可用区架构,通过完善的监控、自动化的故障恢复流程,将单一组件、单一区域故障的影响降到最低。把业务韧性掌握在自己手中,而不是寄托于任何一份协议的字里行间。这才是面对云服务SLA时,最专业、最务实的姿态。

aipay无法跳转充值,咋整呢

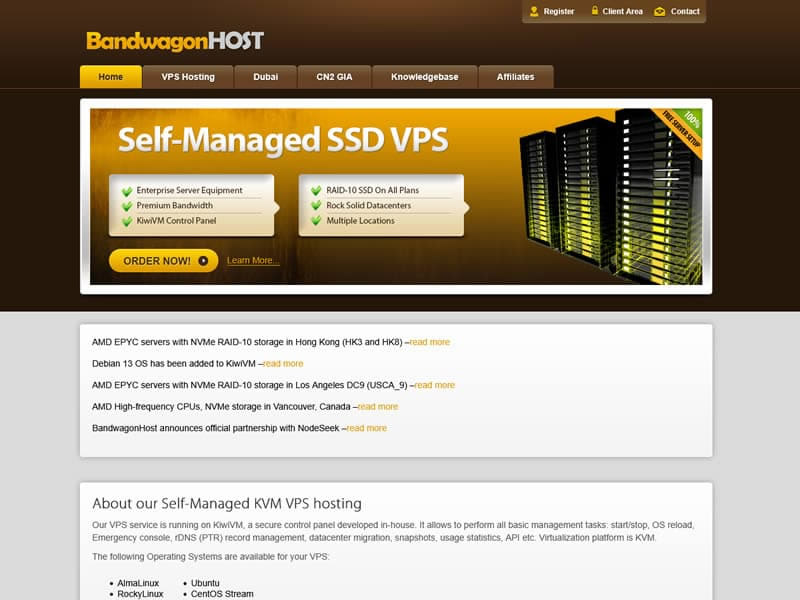

用了几天,发现不分联通电信,在傍晚高峰期都会变得很慢。总体能用,这么便宜还要什么自行车

另外联通测速很好 10M+,电信下载只有100k,上传倒是很快